AI半導体市場で8割以上の圧倒的シェアを誇るNVIDIA。その王者が今、これまで「お得意様」であったはずのクラウドコンピューティング市場へ、自ら乗り込んできました。この動きは、単なる新事業への挑戦ではありません。Amazon Web Services (AWS)、Microsoft Azure、Google Cloudという巨大IT企業が支配してきた「金のなる木」であるクラウド業界の勢力図を根底から覆しかねない、地殻変動の始まりです。

なぜNVIDIAは、最大の顧客と競合する道を選んだのか?その切り札「DGX Cloud」とは何なのか?そして、この「フレネミー(味方であり敵)」という複雑な関係は、AI時代の覇権争いをどこへ導くのか?

本記事では、2025年6月時点の最新情報を基に、NVIDIAの壮大な戦略と、それに揺れるクラウド業界の未来を、誰にでも分かりやすく、そして徹底的に深掘りして解説します。

この記事の結論まとめ

- NVIDIAは単なるチップ供給者からプラットフォーマーへ変貌中

- DGX Cloudでクラウド大手と直接競合し、高収益化を狙う

- 新興クラウド企業への投資で「NVIDIA経済圏」を拡大している

- 垂直統合モデルでAI開発の主導権を完全に掌握する壮大な戦略

- クラウド大手はNVIDIA依存脱却のため自社チップ開発を急ぐ

関連・比較銘柄

- クラウド大手(競合/パートナー): Amazon (AMZN), Microsoft (MSFT), Google (GOOGL), Oracle (ORCL)

- 半導体(競合): AMD (AMD), Intel (INTC)

- 新興クラウド(パートナー): CoreWeave, Lambda Labs (非上場)

- その他半導体: Broadcom (AVGO), Qualcomm (QCOM)

- 日本の関連銘柄まとめ

結論:NVIDIAの狙いは「AIインフラの完全支配」

NVIDIAのクラウド参入は、一見すると自社の首を絞めかねない「奇策」に見えるかもしれません。なぜなら、クラウド大手はNVIDIAのAI向け半導体の売上の半分以上を占める最大の上得意様だからです。しかし、その裏には、単なる「武器商人」の立場に甘んじることなく、AI開発におけるハードウェア、ソフトウェア、クラウドサービスまで全てを包含する垂直統合プラットフォームを構築し、業界の主導権を完全に掌握するという、CEOジェンスン・フアン氏の壮大な野望が隠されています。

この戦略は、主に3つの柱で構成されています。

「武器商人」からの脱却:垂直統合プラットフォーマーへ

NVIDIAはこれまで、AIの計算処理に不可欠なGPUという「武器」を供給する立場でした。しかし、AI開発はGPUがあるだけでは不十分で、それを最大限に活用するためのソフトウェア(CUDA)、ネットワーク、データセンターなど、インフラ全体の最適化が不可欠です。NVIDIAは、自社のGPUに最適化されたクラウドサービス「DGX Cloud」を自ら提供することで、ハードとソフトを一体化した究極のAI開発環境を顧客に提供し、他社が追随できない強力なエコシステム(経済圏)を築こうとしています。

利益率の最大化:中間マージンの排除

これまで、企業がクラウド上でNVIDIAのGPUを利用する場合、AWSやGoogle Cloudなどのクラウド事業者に料金を支払っていました。当然、その料金にはクラウド事業者の利益(中間マージン)が含まれています。NVIDIAがDGX Cloudを通じてGPU性能を直接レンタル提供することで、この中間マージンを排除し、より高い利益率を確保するビジネスモデルを構築しようとしています。UBSのアナリストは、このDGX Cloud事業が将来的には年間売上高100億ドル(約1兆5000億円)を超える巨大事業に成長する可能性があると予測しています。

「NVIDIA経済圏」の創出:新興クラウド勢力の育成

NVIDIAは、大手クラウド事業者と競合する一方で、CoreWeaveやLambda Labsといった新興のGPUクラウド専門企業に積極的に投資し、最新GPUを優先的に供給しています。これは、大手クラウド事業者への一極集中リスクを分散させると同時に、自社の影響下にあるプレイヤーを増やすことで市場全体の競争を促し、結果的にNVIDIA製GPUへの需要をさらに高めるという巧みな戦略です。まさに、大手クラウドの競合を自ら育てているのです。

NVIDIAの切り札「DGX Cloud」の正体

NVIDIAのクラウド戦略の中核をなすのが、2023年に一般提供が開始された「DGX Cloud」です。これは単なるサーバー貸し(IaaS)ではありません。

DGX Cloudの特異な仕組み

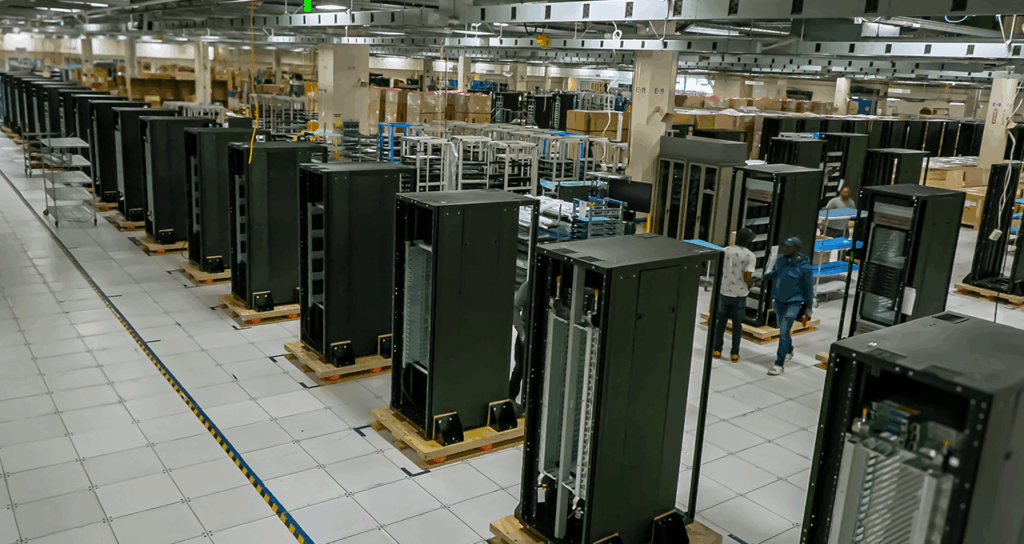

DGX Cloudは、NVIDIAが設計したAIスーパーコンピュータ「DGXシステム」と、AI開発に必要なソフトウェア群「NVIDIA AI Enterprise」をセットで提供するサービスです。驚くべきは、そのインフラがOracle、Google Cloud、Microsoft Azureといった大手クラウド事業者のデータセンター内に設置・運用されている点です。

つまり、**「NVIDIAがサービス主体となり、クラウド大手が場所を提供する」**という、従来の力関係を逆転させた構図なのです。この奇妙な協力関係は、NVIDIAの影響力の絶大さを物語っています。長年のパートナーが突如として競合になり得るこの状況は「フレネミー(Friend + Enemy)」と表現されています。

DGX Cloudがもたらす圧倒的な価値

DGX Cloudの最大の魅力は、企業がWebブラウザから即座に世界最高峰のAIスーパーコンピュータにアクセスできる手軽さです。自前で高価なインフラを構築・管理する複雑さから解放され、月額レンタルで利用できます。

さらに、NVIDIAの専門家による直接サポートが受けられるため、AIモデルの最適化や開発課題を迅速に解決できます。

その効果は劇的です。

- Amgen(バイオテクノロジー): DGX CloudとNVIDIA BioNeMoソフトウェアを活用し、タンパク質大規模言語モデル(LLM)のトレーニングを3倍高速化、トレーニング後の分析は最大100倍高速化しました。

- D社(SaaS企業): 顧客サポートにRAG(検索拡張生成)システムを構築し、対応時間を平均15分から3分に短縮、解決率を67%から94%に向上させ、サポート人員を12名から4名に削減しました。

- B社(金融IT企業): NeMoフレームワークの活用でLLM開発コストを78%削減。年間1.64億円のコスト削減と、3.2億円の追加売上機会を獲得しました。

引用 https://note.com/mask_ai/n/n9e246eb41b9c

このように、DGX Cloudは単なる計算リソースの提供に留まらず、企業のAI開発における生産性を飛躍的に向上させる統合プラットフォームとして機能しています。

| 導入事例 | 業界 | 導入効果 | 出典 |

|---|---|---|---|

| Amgen | バイオテクノロジー | タンパク質LLMのトレーニングを3倍高速化 | |

| CCC Intelligent Solutions | 保険 | AIモデル開発を高速化・拡張 | |

| ServiceNow | デジタルビジネス | ハイブリッドクラウドAIスパコンでLLM研究を強化 | |

| B社 | 金融IT | LLM開発コストを78%削減、年間1.64億円削減 | |

| D社 | SaaS | 顧客サポート効率が300%向上 |

進化し続けるNVIDIAのクラウドサービス

NVIDIAはDGX Cloudを核としながら、さらにサービスを拡大しています。

- DGX Cloud Serverless Inference: AIの推論(実行)フェーズに特化したサービス。開発者はインフラを意識することなく、世界中のクラウドやデータセンターにAIアプリケーションを一度デプロイするだけで、需要に応じて自動でスケールさせることができます。

- DGX Cloud Lepton: 2025年に発表された、GPUリソースのマーケットプレイス(仲介市場)。AI開発者と、NVIDIA認定クラウドパートナー(NCPs)が持つGPUリソースを繋ぎ、GPUの貸し借りを仲介します。これにより、GPUの流動性を高め、開発者が最適なコストでリソースを確保できる環境を目指しています。

このように、NVIDIAはAIモデルの「トレーニング」から「推論」、さらには「リソースの流通」まで、AIライフサイクルのあらゆる段階をカバーするプラットフォームを構築し、その支配力を強固なものにしようとしています。

激震!クラウド業界の勢力図はどう変わるのか?

NVIDIAの参入は、クラウド業界に大きな波紋を広げています。

大手クラウド3強(AWS, Google, Microsoft)のジレンマ

AWS、Google Cloud、Microsoft Azureにとって、NVIDIAは悩ましい存在です。AIサービスを強化するためにはNVIDIAの高性能GPUが不可欠であり、最大の顧客であり続けています。しかし、そのNVIDIAがDGX Cloudで自社のクラウド事業と直接競合し始めたのです。

さらに厄介なのは、DGX Cloudの提供に自社のデータセンターを貸し出さざるを得ない状況です。これは、NVIDIAのGPUを求める顧客を逃さないための苦肉の策であり、NVIDIAの市場における圧倒的な影響力を浮き彫りにしています。

このNVIDIA依存から脱却するため、クラウド大手各社は自社製AIチップの開発を急いでいます。

- Google: TPU (Tensor Processing Unit)

- Amazon: Trainium (学習用), Inferentia (推論用)

- Microsoft: Maia (AIアクセラレーター)

これらのカスタムチップは、自社サービスに最適化することでコストを削減し、NVIDIAへの依存度を下げることが狙いです。しかし、NVIDIAが長年かけて築き上げてきた**「CUDA」というソフトウェア・プラットフォームの壁**は高く、代替は容易ではありません。多くのAI開発者や研究者がCUDAに慣れ親しんでおり、このエコシステムから離れるのは困難なのが実情です。

NVIDIAが育てる「第4勢力」の台頭

大手クラウドがNVIDIAとの複雑な関係に苦慮する一方、NVIDIAの強力な支援を受ける新興クラウド企業が急速に存在感を増しています。CoreWeaveやLambda Labsといった企業は、NVIDIAから最新GPUの優先供給や出資を受け、大手よりも安価で高性能なGPUクラウドサービスを提供し、多くのスタートアップから支持を集めています。

NVIDIAは、これらの企業を育成することで、大手3強の寡占状態に風穴を開け、市場に健全な競争を生み出そうとしています。これは、自社製GPUの販路を多様化し、価格交渉力を維持するための巧妙な戦略と言えるでしょう。

NVIDIAの死角と未来 – 盤石な支配は続くのか?

現在のNVIDIAは向かうところ敵なしに見えますが、その未来は決して安泰ではありません。

市場に潜む懸念材料

一部のアナリストからは、NVIDIAの急成長に対する慎重な見方も出ています。

- 収益のピークアウト懸念: AIインフラへの初期投資が一巡した後、2026年頃から収益が循環的な下降局面に入る可能性が指摘されています。

- ダブルオーダーリング: 供給不足を懸念した主要顧客が、必要以上の量を重複して発注している可能性があり、将来の需要が過大評価されているリスクがあります。

- 競争の激化: AMDやIntelといった競合他社や、多くのスタートアップがAIチップ市場に参入し、競争は激化の一途をたどっています。特に、特定のタスクに特化した、より電力効率の高い代替チップが登場すれば、NVIDIAの牙城を崩す可能性があります。

次なる戦場は「産業特化型AI」

汎用的なクラウド市場での競争が激化する中、NVIDIAは次なる一手として**「産業特化型AIクラウド」**に照準を合わせています。

2025年6月、NVIDIAはドイツに世界初の産業用AIクラウドを構築すると発表しました。これは、BMWグループ、シーメンス、ボルボ・カーズといった欧州の製造業リーダーと連携し、製品設計、シミュレーション、工場のデジタルツイン、AI駆動の物流など、製造業のあらゆるプロセスを高速化するための「AIファクトリー」です。

この動きは、NVIDIAが汎用的なコンピューティングリソースの提供から、特定の産業(インダストリー)の課題解決に深くコミットするソリューションプロバイダーへと進化しようとしていることを示唆しています。製造業、ヘルスケア、金融など、各業界に特化したプラットフォームを提供することで、より高い付加価値を生み出し、競合との差別化を図る戦略です。

結論:AI時代の覇権をかけた地殻変動は始まったばかり

NVIDIAのクラウド参入は、単なる事業拡大ではありません。それは、AIチップという根幹技術を握る企業が、その力を最大限に活用してAI時代のコンピューティング・インフラ全体を再定義しようとする壮大な挑戦です。

短期的には、NVIDIAとクラウド大手との「フレネミー」関係は続くでしょう。しかし長期的には、NVIDIAが設計するハードウェアとソフトウェアの統合プラットフォームが業界標準となり、その上で様々な企業がサービスを展開するという構図が強まる可能性があります。

この地殻変動はまだ始まったばかりです。投資家、開発者、そしてあらゆるビジネスパーソンは、AIの王者が仕掛けるこの壮大なゲームの行方を、固唾をのんで見守る必要があるでしょう。

日本のNVIDIA関連銘柄

日本国内においても、NVIDIAとの関係は深化しており、多くの企業がそのエコシステムの中で重要な役割を担っています。

販売パートナー / 代理店

NVIDIAの製品・ソリューションを国内の企業や研究機関に提供する、いわば「NVIDIAの顔」となる企業群です。

- ジーデップ・アドバンス (5885): NVIDIAの最上位パートナー「Elite Partner」。NVIDIA DGXシリーズなどのスーパーコンピュータや、最新GPUを搭載したサーバーの販売、プライベートクラウドサービス「GX CLOUD」の提供など、NVIDIAの最先端ソリューションを国内で展開しています。

- SB C&S (ソフトバンクグループ): NVIDIAのディストリビューターとして「NVIDIA Partner Network Award」で最優秀賞を受賞するなど、強力な販売網を持っています。

- マクニカ (3132): 半導体商社として長年の実績を持ち、NVIDIAの主要な代理店の一つです。

- 菱洋エレクトロ (8068): マクニカと同様、NVIDIA製品を取り扱う半導体商社です。

GPUクラウド / データセンター事業者

NVIDIA製の高性能GPUを大規模に導入し、国内で生成AI開発などに向けたクラウド基盤を提供する企業です。

- さくらインターネット (3778): NVIDIAから最新GPUを大量に調達し、政府の「クラウドプログラム」にも認定された大規模GPUクラウドサービス「高火力」を提供しています。

- GMOグローバルサイン・ホールディングス (3788): 自社のデータセンターを基盤に、NVIDIAの最新GPUを活用したGPUクラウド事業に参入しています。

半導体製造関連(サプライチェーン)

NVIDIAの高性能GPUの製造プロセスにおいて、不可欠な装置や部材を供給する企業群です。

- アドバンテスト (6857): 製造された半導体チップが正常に動作するかを検査する「テスター」の世界的企業。NVIDIAのGPUのような高性能半導体の品質保証に不可欠です。

- 東京エレクトロン (8035): 半導体製造工程で使われる成膜装置やエッチング装置などで世界トップクラスのシェアを誇ります。

- 信越化学工業 (4063): 半導体の基板となるシリコンウエハーで世界首位。高品質なウエハーがNVIDIA製品の性能を支えています。

協業 / ソリューションパートナー

NVIDIAの技術を活用したソリューション開発や、特定の技術分野で協業関係にある企業です。

- 富士通 (6702): NVIDIAのGPU間を高速接続する技術「NVLink」の採用などで協業。また、自社のAIサービス「Fujitsu Kozuchi」の開発も進めています。

- TDSE (7046): ジーデップ・アドバンスと協業し、NVIDIA DGX B200上で動作するAI開発プラットフォーム「Dify」を活用したサービスを提供しています。

- トヨタ自動車 (7203): 自動運転技術の開発において、NVIDIAのSoC(System-on-a-Chip)「DRIVE」シリーズを採用するなど、長年にわたり協力関係にあります。

最近のニュース&材料(2025年6月時点)

- 産業用AIクラウドをドイツに構築 (2025/06/11): 欧州の製造業向けに、10,000基のGPUを搭載したAIファクトリーを建設すると発表。BMWやシーメンスなどが参画し、製造業のデジタルツインやAI活用を加速させます。株価にはポジティブな材料と見られます。

- DGX Cloud Leptonを発表 (2025年): AI開発者とクラウドプロバイダーを繋ぐGPUマーケットプレイスを発表。GPUリソースの流動性を高め、エコシステムの拡大を狙います。

- Blackwellアーキテクチャの出荷遅延の可能性: 次世代GPU「Blackwell」の出荷が2025年春以降に遅れる可能性が報じられています。これは、液冷対応の新しいデータセンター建設を進めるクラウド事業者にとって大きな影響を与える可能性があります。短期的な株価の懸念材料となるかもしれません。

- 日本市場への注力: ソフトバンクがNVIDIA Blackwellを採用した国内最強クラスのAIスパコンを構築するなど、日本国内でもNVIDIA AIプラットフォームの導入が加速しています。日本のAI市場規模は2028年に約2.5兆円まで拡大すると予測されており、NVIDIAにとって重要な市場となっています。

よくある質問(FAQ)

- NVIDIAのDGX Cloudは、AWSやGoogle Cloudとどう違うのですか?

-

DGX Cloudは、単にサーバーを貸すサービス(IaaS)ではありません。NVIDIAが自社のGPUに最適化したハードウェア(DGXシステム)と、AI開発用のソフトウェア(NVIDIA AI Enterprise)、専門家によるサポートまでをワンパッケージで提供するPaaS(Platform as a Service)に近いサービスです。これにより、ユーザーはインフラの複雑な設定から解放され、すぐにAI開発に集中できるのが最大の違いです。

- なぜクラウド大手は、競合となるNVIDIAのサービスを自社データセンターで提供するのですか?

-

主に2つの理由があります。第一に、NVIDIAのGPUはAI開発に不可欠であり、DGX Cloudを求める顧客を他社に奪われたくないためです。第二に、NVIDIAはGPU供給元として絶大な力を持っており、その意向を無視できないという力関係があります。自社でホストすることで、少なくともインフラ利用料は収益として確保できるという側面もあります。まさに「フレネミー」関係の象徴的な状況です。

- NVIDIAの独占はいつまで続く?競合の勝機はどこにありますか?

-

NVIDIAの強みは、GPUの性能だけでなく、長年かけて築き上げたソフトウェア・エコシステム「CUDA」にあります。これを覆すのは容易ではありません。しかし、競合にも勝機はあります。AMDやIntelは、よりコストパフォーマンスに優れた製品で市場シェアを狙っています。また、特定の用途(推論など)に特化し、電力効率に優れたチップを開発するスタートアップも脅威です。クラウド大手による自社チップ開発も、長期的にはNVIDIAのシェアを脅かす可能性があります。

- 「フレネミー(Frenemy)」とはどういう意味ですか?

-

「フレンド(Friend、味方)」と「エネミー(Enemy、敵)」を組み合わせた造語です。NVIDIAと大手クラウド事業者の関係を的確に表す言葉として使われています。クラウド事業者はNVIDIAからGPUを購入する「顧客(味方)」でありながら、クラウドサービス市場では「競合(敵)」でもあるという、協力と競争が入り混じった複雑な関係を指します。

- 日本企業への影響はどうなりますか?

-

大きなチャンスと課題の両方があります。DGX Cloudのようなサービスにより、これまで巨額の初期投資が必要だった最先端のAI開発環境が、より手軽に利用できるようになります。これにより、スタートアップや中小企業でも革新的なAIサービスを生み出すチャンスが広がります。一方で、NVIDIAのプラットフォームをいかに早く導入し、活用できるかが企業の競争力を左右する時代になり、導入格差が企業格差に直結する可能性があります。SCSKなどがNVIDIAと連携し、企業向けにDGX H100の検証サービスを提供するなど、導入支援の動きも活発化しています。

- NVIDIAの株価は今後どうなると考えられますか?

-

短期的には、Blackwellの出荷動向やマクロ経済の影響を受けますが、長期的にはAI市場の拡大とともに成長が期待されます。クラウド事業の成功は、NVIDIAを単なる半導体メーカーから高収益なプラットフォーム企業へと変貌させ、さらなる株価上昇の要因となる可能性があります。ただし、競争激化や需要のピークアウト懸念といったリスクも存在するため、楽観は禁物です。

- DGX Cloudの具体的な料金はいくらですか?

-

2023年3月の発表時点では、DGX Cloudインスタンスは月額36,999ドル(約550万円)からとされています。これは8基のH100またはA100 GPUを搭載したインスタンスあたりの価格です。企業はプロジェクトの規模や需要に応じて、必要な数のインスタンスをレンタルすることができます。

コメント